Pensez à votre objectif, comprenez les exigences en matière de données, sélectionnez les bons outils de Big Data, etc.

C’est le deuxième article sur l’initiative Big Data. Vous pouvez lire le premier :

Dans le monde des affaires aujourd’hui, les données sont la nouvelle ressource la plus importante qui a le pouvoir de transformer chaque secteur d’activité.

Les entreprises qui n’ont pas profité des données qu’elles collectent sont laissées pour compte. Par conséquent, il n’est pas surprenant que beaucoup de sociétés souhaitent vivement utiliser l’analyse du Big Data.

Étant donné l’énormité du big data – et la certitude qu’il ne fera que s’agrandir – les entreprises se tournent vers le cloud pour leurs besoins en big data. Le cloud offre divers avantages, notamment l’évolutivité, la flexibilité et les économies de coûts. Il peut aider les entreprises de toutes tailles à tirer parti de leurs mégadonnées ou big data.

Pourtant, la migration vers le cloud à des fins de Big Data peut être décourageante. Il est important d’avoir un plan et une stratégie. Il faut aussi adopter une approche méthodique pour votre migration vers le cloud Big Data.

Dans cet article, nous allons aborder huit étapes clés à prendre en compte pour garantir le passage vers le cloud afin d’atteindre vos objectifs Big Data.

1) Identifiez votre objectif principal

Démarrer un projet Big Data uniquement dans le but d’explorer des possibilités, sans objectif clair, est une énorme perte de temps, d’efforts et de ressources.

De nombreuses entreprises ont appris à leurs dépens. Ainsi, 85 % des projets Big Data échouent. C’est ridicule !

Ce taux d’échec élevé n’a pas grand-chose à voir avec la technologie elle-même. Ceci étant, les entreprises n’ont pas souvent une vision claire des informations qu’elles souhaitent extraire de leurs données et de leur impact sur leurs activités.

Pour augmenter vos chances de réussite, vous devez identifier les buts et objectifs clés que vous voulez atteindre de vos projets Big Data. Voici quelques questions à poser :

- Quels sont les objectifs principaux que vous aimeriez atteindre en analysant mieux vos données ?

- Comment ces objectifs correspondent-ils à votrestratégie commerciale globale?

- Quelles unités commerciales seront les plus touchées ?

- À quoi ressemble une implémentation réussie de Big Data ?

Il est impératif d’établir dès le début comment définir un projet réussi afin que chacun sache vers quoi s’atteler.

Une fois que vous avez clarifié vos objectifs, vous pouvez puiser dans les détails de votre implémentation de Big Data.

2) Comprendre vos besoins en infrastructure de stockage de données

L’étape suivante consiste à comprendre vos données et l’infrastructure de base de données requise pour les stocker et les analyser.

Votre analyse doit inclure les facteurs suivants :

- Le type de données que vous stockerez et analyserez

- La quantité de données dont vous aurez besoin pour analyser

- La rapidité avec laquelle vous avez besoin de résultats analytiques

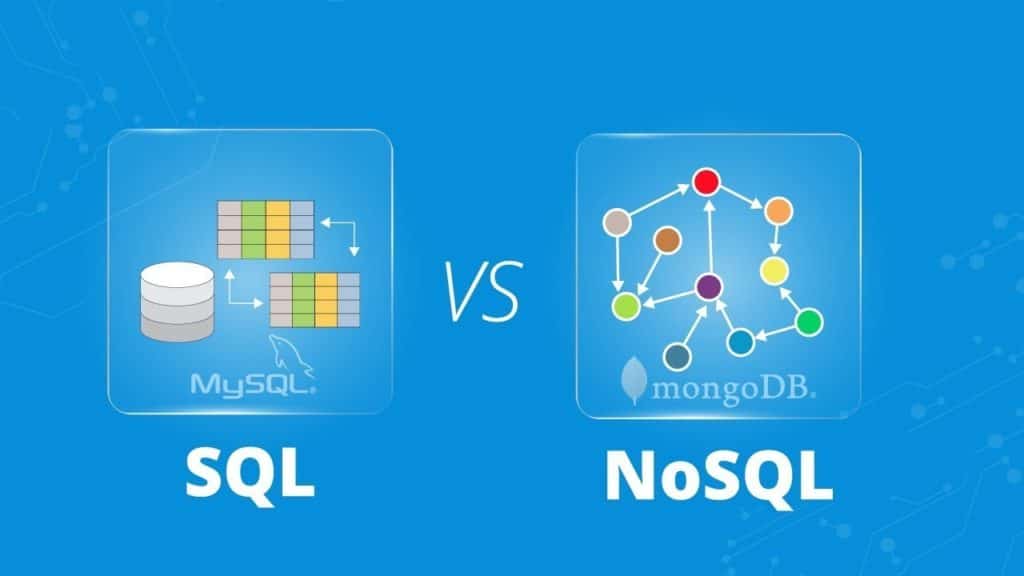

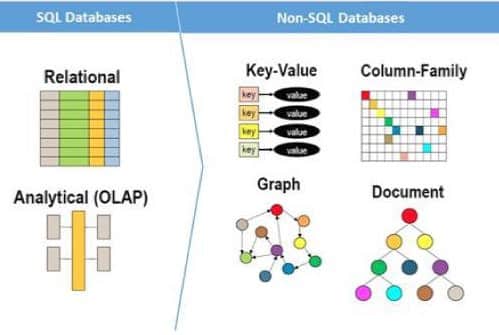

Bases de données SQL vs NoSQL

Si le type de données que vous stockez et analysez est principalement bien organisé et structuré, une base de données SQL (langage de requête structuré) est probablement la meilleure option.

Les bases de données SQL sont parfaites pour les données relationnelles, telles que les données comptables, les informations sur les clients, les données d’inventaire de vente au détail et d’autres données qui peuvent être soigneusement organisées en lignes et colonnes.

Les offres de base de données SQL incluent MySQL, Microsoft SQL Server, PostgreSQL, Oracle et bien d’autres. Bien sûr, les principaux fournisseurs de cloud computing ont des versions cloud des bases de données SQL. AWS a RDS et Aurora, Azure a SQL Database et Google Cloud Platform (GCP) a Cloud SQL.

Cependant, l’essor des mégadonnées et l’adoption généralisée de l’informatique distribuée ont ouvert la voie à une technologie de base de données plus flexible : NoSQL (pas seulement SQL).

Alors que SQL fonctionne pour les données conformes aux schémas relationnels, NoSQL est beaucoup plus flexible et s’applique à d’autres types de données non structurées. Ce sont des données de médias sociaux, de capteurs et d’autres formes de données générées par l’homme et la machine.

NoSQL est meilleur dans le traitement et le stockage des données en temps réel. Il évolue horizontalement, ce qui le rend idéal pour l’ingestion et la gestion de volumes massifs de données.

Les solutions de base de données NoSQL sont MongoDB, Redis, Cassandra et bien d’autres. Les options cloud comprennent Amazon DynamoDB, Azure CosmosDB et Google Cloud Bigtable.

Alors, cela rend-il NoSQL meilleur pour l’analyse du Big Data ? Pas exactement. Par définition, les mégadonnées ou big data englobent les données structurées et non structurées.

Les deux ont le potentiel de révéler des informations importantes. Le choix d’utiliser une base de données SQL ou NoSQL dépend de votre situation particulière.

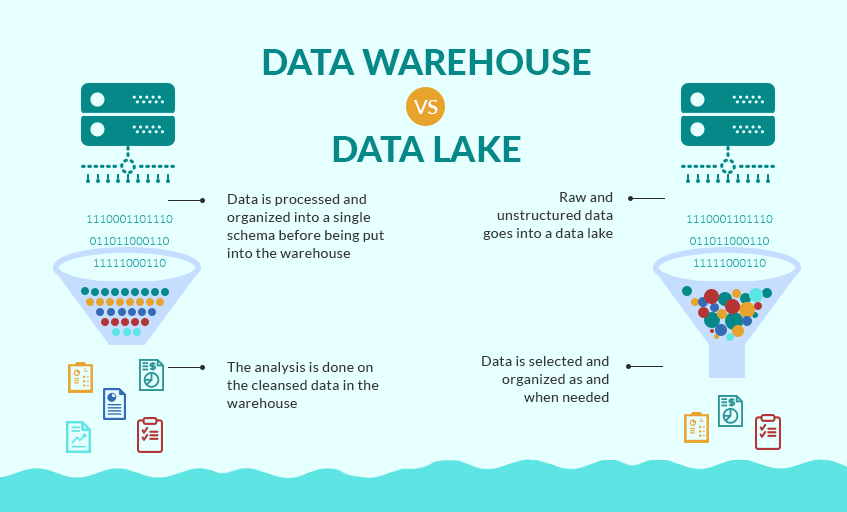

Lacs de données et entrepôts

Pour l’infrastructure, il faut aussi considérer si vous aurez besoin d’un lac de données ou d’un entrepôt de données.

Un lac de données est un référentiel central qui peut stocker des données structurées ou non structurées telles quelles, sans aucun type de traitement ou de modélisation. Les données stockées peuvent être sous leur forme la plus brute et vous pouvez adopter une approche « tout stocker » avec un lac de données. Amazon S3 et Glacier, Azure Data Lake Storage et Google Cloud Storage sont souvent utilisés comme solutions des lacs de données.

Les entrepôts de données sont par contre des référentiels de données centraux. Ces derniers intègrent des données provenant de plusieurs sources, telles que des bases de données, des systèmes transactionnels, des lacs de données et d’autres sources.

Ces données doivent être traitées et normalisées afin que vous puissiez exécuter facilement et rapidement des rapports. Les solutions d’entrepôt de données cloud sont Amazon Redshift, Azure SQL Data Warehouse et Google Cloud BigQuery.

L’un des développeurs de logiciels, Robert Chen, a proposé cette analogie :

Un lac de données serait votre garde-manger de cuisine et votre réfrigérateur. C’est là que vous stockez tous les types de nourriture. Tandis qu’un entrepôt de données serait votre comptoir de cuisine où vous réunissez les ingrédients dont vous avez besoin pour faire le dîner. C’est assez bien !

3) Trouvez les bons outils Big Data pour vos besoins d’analyse

Lorsque vous avez fait une évaluation approfondie de la façon dont vos données doivent être stockées et gérées, il est temps de décider des outils qui vous permettront d’extraire au mieux les informations analytiques de vos données.

Nous allons écrire certainement plus sur les outils de Big Data dans les prochains articles, mais voici un aperçu de certains des outils les plus courants pour diverses utilisations.

Stockage et traitement des données distribués

En raison de la « taille » de vos données, un outil de traitement de données distribué peut être nécessaire pour gérer et traiter efficacement toutes vos données.

Hadoop et Spark sont devenus deux des outils open source les plus couramment utilisés. Ils permettent le traitement distribué de grands ensembles de données.

Hadoop, à travers ses différents modules, divise les mégadonnées et les distribue sur de nombreux nœuds d’un cluster. Ainsi, les données puissent être traitées en parallèle.

Spark est spécialisé dans le traitement en temps réel et en mémoire utilisant un concept connu sous le nom de RDD (Resilient Distributed Dataset). Il est donc plus rapide que Hadoop.

Cependant, il ne fait pas de stockage distribué contrairement au Hadoop. Hadoop et Spark peuvent certainement travailler ensemble pour atteindre la vitesse et l’efficacité dont vous avez besoin.

Ces outils peuvent être installés sur site, mais sont idéaux pour le déploiement dans des environnements cloud. Les principaux fournisseurs cloud ont tous des offres de services qui peuvent exécuter des clusters Hadoop ou Spark. AWS a Elastic MapReduce, Azure a HDInsight et DataBricks, et Google Cloud propose Cloud Dataproc.

Surveillance et retour d’informations en temps réel

La surveillance et l’analyse des données en temps réel peuvent faciliter la prise de décision instantanément.

Associée à des alertes immédiates, l’analyse des données en temps réel peut aider votre entreprise à prendre des décisions opérationnelles rapides pour améliorer la satisfaction clientèle.

Les cas d’utilisation de l’analyse des données en temps réel incluent la détection des fraudes par carte de crédit, la reconnaissance des urgences en matière de soins de santé, l’identification des défaillances du système logiciel, et bien d’autres.

Certaines des meilleures plateformes d’analyse de streaming pouvant être utilisées pour l’analyse de données en temps réel comprennent Amazon Kinesis, Azure Stream Analytics, Google Cloud Stream Analytics et Apache Storm. Elles sont toutes conçues pour collecter et analyser des données en temps réel à partir de et dans le cloud. Ce qui en fait des applications idéales pour former la base de votre pipeline d’analyse de données en temps réel.

Création de rapports et de tableaux de bord

Les graphiques et les visualisations permettent aux analystes et aux décideurs d’évaluer facilement les informations en un coup d’œil. C’est pourquoi les outils de visualisation des données sont une partie si importante de la pile d’analyse.

Que vous optiez pour des outils basés sur le cloud, des fournisseurs établis ou des petits acteurs spécialisés dans certaines industries, les outils de visualisation de données ne manquent pas sur le marché.

Tableau est l’une des options les plus populaires, tout comme Domo, Qlik et autres. Amazon propose QuickSight. Azure a Power BI. GCP fournit divers outils comme Data Studio que vous pouvez lier à BigQuery pour alimenter vos tableaux de bord de Business Intelligence.

4) Comprendre vos exigences de sécurité et de conformité

Plus vous disposez de données, plus vous pouvez extraire de précieuses informations. Mais vous devez également faire plus attention à la protection de la sécurité et de la confidentialité de toutes ces données.

Ce n’est pas un secret que les violations de données peuvent entraîner de graves ramifications. La mise en danger des informations personnelles identifiables de vos clients peut entraîner des pertes financières, des sanctions réglementaires et des atteintes à la réputation. Ainsi, même si vous voulez trouver de la valeur dans les mégadonnées, vous ne pouvez pas le faire au détriment de la sécurité et de la confidentialité.

Les mégadonnées ont des exigences de sécurité uniques en raison de leur volume et de leur variété (données massives, structurées et non structurées), du stockage dispersé (sur site ou dans le cloud), du traitement distribué (sur plusieurs nœuds de cluster) et de divers outils d’infrastructure et d’analyse.

De plus, lorsque vos données sont dans le cloud, vous devrez travailler en étroite collaboration avec votre fournisseur de services cloud pour négocier des SLA de sécurité solides.

Il n’y a pas de solution unique en matière de sécurité des mégadonnées. Les professionnels de la sécurité informatique recommandent un mélange de techniques personnalisées pour votre plateforme de Big Data. Certaines des technologies et des outils qui pourraient être intégrés à votre solution de sécurité des mégadonnées sont :

- Outils de chiffrement qui fonctionnent avec différents types de données et de formats de stockage

- Un système de gestion des clés centralisé qui englobe l’équipement, les politiques et les processus concernant la manipulation des clés

- Politiques de contrôle d’accès utilisateur strictes

- Systèmes de détection et de prévention des intrusions

De telles techniques sont non seulement essentielles pour atténuer les risques de sécurité, mais également pour se conformer aux normes réglementaires toujours plus strictes.

Par exemple, si vous utilisez des données de résidents de l’UE, vous devez vous assurer que vos processus de collecte, de stockage, de traitement et d’analyse de ces données sont conformes au RGPD récemment promulgué.

Cela signifierait que même l’emplacement de votre centre de données pourrait devenir un problème. Utiliser un modèle cloud privé ou hybride serait la meilleure option pour votre entreprise (plus d’informations sur les modèles cloud dans la section suivante).

Malgré l’absence de normes dans ce secteur pour la sécurisation des mégadonnées, les entreprises doivent toujours considérer la sécurité comme un facteur primordial à chaque étape du traitement des données.

Le but est d’amener toutes les personnes de votre entreprise – gestion, équipe de données et équipe de sécurité informatique – à considérer la sécurité des données comme un objectif commun qui nécessite des efforts concertés pour y parvenir.

5) Choisissez le meilleur modèle cloud pour votre situation

L’une des décisions importantes que vous devrez prendre lors du transfert de vos données vers le cloud est de savoir s’il faut utiliser un modèle cloud public, privé ou hybride.

Vous devrez vous penchez sur les coûts, l’efficacité technique et les exigences de sécurité et de conformité avant de prendre une décision. Vous trouverez ci-dessous un aperçu rapide de chaque modèle cloud.

Cloud public

Dans un cloud public, il y a un « partage » de matériel physique entre les entreprises, tandis que l’ensemble de l’infrastructure cloud est détenu et exploité par un fournisseur de services cloud tiers comme Amazon, Microsoft ou Google.

Le plus grand avantage du cloud public est sa capacité à faire évoluer à l’infini les ressources d’infrastructure à tout moment sans avoir besoin d’investissements initiaux. Ce sera très utile à mesure que la quantité de données augmente.

De plus, l’utilisation des services cloud public vous permet de tirer parti des technologies de pointe les plus récentes pour vos initiatives d’analyse. Si vous voulez en savoir plus consultez notre article les avantages du cloud public.

Cloud privé

Si vous avez besoin d’une configuration plus personnalisée et d’un contrôle maximal sur vos données, un cloud privé peut être la meilleure option pour votre initiative Big Data.

Dans ce modèle, vos données résident dans un environnement cloud mais l’infrastructure utilisée n’est pas partagée avec plusieurs entreprises. Elle est entièrement dédiée à votre entreprise. Les clouds privés peuvent être maintenus sur site ou dans un centre de données tiers.

Avec un cloud privé, vous avez une connaissance et un contrôle complets des pratiques de sécurité et des principes de gestion des données utilisés. Ce serait avantageux à des fins de sécurité et de conformité, mais a un coût et des frais généraux de gestion beaucoup plus élevés.

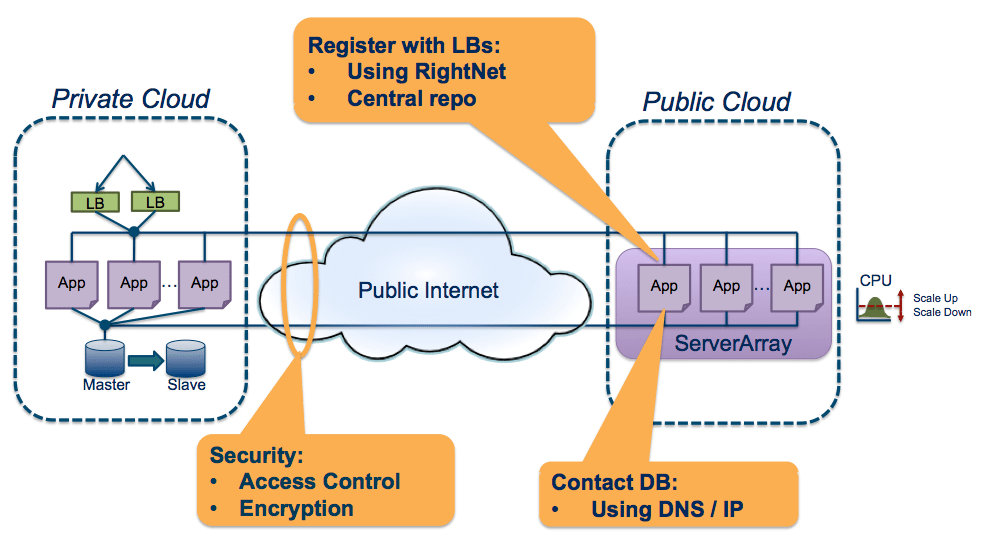

Cloud hybride

Les entreprises recherchant une option qui leur offrira le meilleur des deux mondes en termes de personnalisation, d’évolutivité, de sécurité et de rentabilité peuvent opter pour un environnement cloud hybride.

Un cloud hybride combine un cloud public et privé. Tous les deux fonctionnent de manière indépendante mais communiquent via l’orchestration. Vous pouvez personnaliser votre implémentation de cloud hybride en fonction de vos besoins.

Un exemple d’utilisation de clous hybride serait le stockage de données confidentielles dans votre cloud privé lors de l’exécution de requêtes analytiques sur des données moins sensibles via un service cloud public.

Bien que les clouds hybrides offrent certainement de nombreux avantages, ils nécessitent un niveau supérieur de gestion technique et d’orchestration.

6) Évaluer les fournisseurs cloud offrant des services Big Data

Après avoir effectué les étapes 1 à 5, vous devriez avoir une meilleure idée de tout ce dont vous avez besoin pour lancer votre initiative Big Data dans le cloud. Il est maintenant temps de sélectionner le fournisseur cloud qui peut vous fournir la plupart ou tout ce dont vous avez besoin.

Recherchez les fournisseurs qui offrent les outils dont vous avez besoin et ont mis en œuvre les architectures similaires dont vous avez besoin. Parlez à leurs clients pour en savoir plus sur leur satisfaction à l’égard de leurs solutions. Déterminez le niveau de service client dont vous aurez besoin et assurez-vous qu’ils peuvent le fournir.

La sélection de votre fournisseur de services cloud est très importante, alors prenez le temps de bien le choisir. Quoi qu’il en soit, si vous avez fait les étapes 1 à 5, cela devrait être relativement simple.

7) Rassemblez le bon talent

Construire une équipe Big Data pourrait être l’un des plus grands défis auxquels vous puissiez faire face.

Tout d’abord, il n’y a pas beaucoup de professionnels du big data. C’est un problème qui ne sera pas résolu aussitôt.

Deuxièmement, la constitution de votre propre équipe nécessitera un investissement substantiel, surtout si vous ne disposez pas des talents nécessaires en interne.

Mais c’est une étape cruciale si votre entreprise est déterminée à adopter un processus de prise de décision basé sur les données. Les mégadonnées ne concernent pas uniquement les données et la technologie ; le côté humain de l’équation est tout aussi ou plus important.

Alors, par où commencer ? Penser à votre équipe existante devrait être l’un de vos premiers pas.

Avez-vous déjà un analyste d’entreprise qui peut faire la transition vers l’analyse des mégadonnées dans le cloud ? Dans votre équipe de développement, y-a-t-il une personne qui possède également les compétences nécessaires pour le développement de logiciels de données ? Les personnes au sein de votre entreprise qui connaissent déjà l’entreprise (et de préférence, qui possèdent le dynamisme pour atteindre les objectifs commerciaux) pourraient être des bons candidats pour votre équipe dédiée.

Pour compléter votre équipe Big Data, vous devrez toujours embaucher en interne les talents techniques qui vous manquent. Une équipe Big Data idéale devrait être composée des membres clés suivants :

- Ingénieurs Cloud

- Développeurs de logiciels

- Ingénieurs et architectes de données

- Scientifiques des données

- Analystes d’affaires

Une fois que vous avez constitué votre équipe, assurez-vous qu’ils comprennent leurs responsabilités non seulement dans leurs rôles individuels, mais aussi dans l’évangélisation d’un mouvement axé sur les données au sein de votre entreprise.

Si la création de toute cette équipe à partir de zéro est une tâche trop ardue, vous pouvez aussi envisager des services gérés de Big Data tiers. Avec la bonne équipe de données externalisées, vous pouvez réaliser un retour sur investissement plus rapidement. En effet, vous n’aurez pas à consacrer beaucoup de temps au recrutement initial des membres de l’équipe. Lorsque vous avez atteint un état stable avec votre équipe externalisée, vous pouvez continuer à construire votre équipe interne pour l’avenir.

8) Exécutez votre plan

Si vous avez suivi les étapes décrites ci-dessus pour lancer votre initiative Big Data Cloud, vous devez maintenant mettre votre plan en action. Cela nécessite de préparer vos données, de mettre en place tous vos outils et de communiquer la vision, les rôles et les responsabilités à votre équipe de données.

Commencez petit en vous concentrant sur votre objectif identifié. Mais, prenez note d’autres cas d’utilisation potentiels pour les mégadonnées pouvant être découverts au cours du processus.

Bien que la mise en œuvre impliquerait principalement l’équipe Big Data et d’autres parties prenantes du projet, votre entreprise devrait encourager une culture axée sur les données. Cela permet ainsi de transformer tout succès avec votre initiative initiale de Big Data en projets futurs.

Conclusion

Un plan bien pensé est important pour réussir votre initiative Big Data Cloud.

Tout commence par la définition de vos objectifs. C’est là que vous comprendrez l’infrastructure et les outils dont vous avez besoin, le modèle cloud à mettre en œuvre et avec qui vous allez travailler.

Ensuite, c’est la constitution de votre équipe et son exécution.

Passer du temps sur les huit considérations ci-dessus vous mettra en bonne position pour atteindre vos objectifs Big Data Cloud.

Aimez-vous cet article ? Il vous aime aussi. Veuillez le partager en utilisant les boutons de partage à gauche ! Pour être informé de nos futures publications Big Data dans le Cloud, inscrivez-vous à notre newsletter ci-dessous.