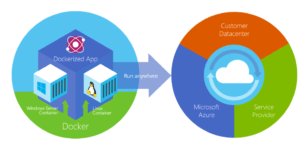

Mis à jours 30 septembre 2020 Les conteneurs explosent au niveau de la scène du développement d’applications, en particulier lorsqu’il s’agit de cloud computing. C’est en grande partie à cause de la portabilité qui a été un gros gouffre dans ce domaine, compte tenu de la nature exclusive de certains cloud publics, et cette technologie abstrait les applications dans des conteneurs virtuels qui peuvent être déplacés de cloud en cloud.

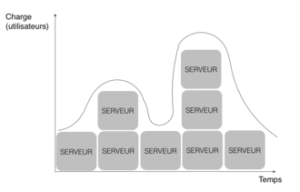

L’architecture des conteneurs est l’autre avantage majeur. Il existe maintenant un moyen standard de diviser les applications en objets ou conteneurs distribués. Diviser les applications de cette façon offre la possibilité de les placer sur différentes machines physiques et virtuelles, dans le cloud ou non. Cette flexibilité offre plus d’avantages autour de la gestion de la charge de travail et permet de créer facilement des systèmes tolérants aux défaillances.

En outre, avec l’utilisation de la technologie de clustering, de planification et d’orchestration, les développeurs peuvent s’assurer que les applications qui existent à l’intérieur des conteneurs peuvent évoluer et sont résilientes. Ces outils peuvent gérer des groupes de conteneurs grâce à une couche de gestion de conteneur bien définie qui fournit ces fonctionnalités. À mesure que le monde des conteneurs continue d’émerger, il devient difficile de créer des applications de conteneur sans ces couches de gestion.

Enfin, la popularité des conteneurs a conduit de nombreuses grandes entreprises, telles qu’AWS, HP, IBM et d’autres à leur prêter allégeance. Cela fournit un support directement à partir des outils et technologies d’entreprise existants. De nombreuses startups bien financées apparaissent également, avec des solutions innovantes pour rendre le développement de conteneurs beaucoup plus intéressant et productif.

Qu’est-ce que tout cela signifie pour les ingénieurs logiciels ? Afin de répondre à cette question, voici un guide pour ceux qui sont en charge du développement d’applications pour les aider à tirer profit des conteneurs logiciels. Il est concentré uniquement sur ce qui est important.

Les bases

Docker, la norme de conteneur la plus populaire, est un projet open-source qui permet d’automatiser le déploiement d’applications dans des conteneurs de logiciels. Docker a vraiment commencé le mouvement de conteneur. Cependant, ce n’est pas la seule possibilité qui existe. Des entreprises telles que CoreOS ont leur propre norme de conteneur appelée Rocket, et de nombreuses normes et des produits sont construits autour de ces technologies.

Ne laissez pas les conteneurs vous effrayer. Ce type d’approche n’a rien de nouveau – les conteneurs ont été utilisés pendant des années comme une approche pour composer des systèmes entiers, les abstrayant de la plate-forme physique, vous permettant de les déplacer d’une plate-forme à l’autre.

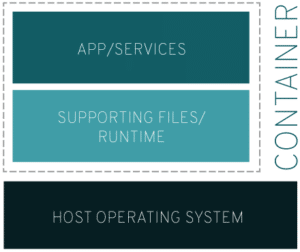

Le noyau Linux, qui se trouve dans le conteneur, permet l’isolation des ressources (processeur, mémoire, Entrée/Sortie, réseau, etc.) et ne nécessite pas le démarrage de machines virtuelles. Docker étend un format de conteneur commun appelé Linux Containers (LXC), avec une API de haut niveau qui fournit une solution de virtualisation légère exécutant les processus de manière isolée. Docker fournit également des espaces de noms pour isoler complètement la vue d’une application sur l’environnement d’exploitation, y compris les arbres de processus, le réseau, les ID utilisateur et les systèmes de fichiers.

L’utilisation de cette technologie est plutôt passionnante, considérant qu’elle résout un problème évident et coûteux : Comment fournir une véritable portabilité d’application parmi les plateformes de cloud ? Alors que les charges de travail peuvent certainement être placées dans des machines virtuelles, l’utilisation de conteneurs est une approche bien meilleure, et devrait avoir une plus grande chance de succès à mesure que le cloud computing passe des architectures simples aux architectures complexes.

La possibilité de fournir une abstraction de plate-forme légère dans le conteneur Docker, sans recourir à la virtualisation, est beaucoup plus efficace pour créer des ensembles de charges de travail transportables entre les clouds. Dans de nombreux cas, la virtualisation est trop lourde pour la migration de la charge de travail. Ainsi, les conteneurs fournissent une base réelle pour déplacer les charges de travail dans des environnements hybrides ou multi-cloud sans avoir à modifier une grande partie de l’application.

Qu’est-ce qui est important ?

Les conteneurs ont quelques caractéristiques et avantages de base, notamment la capacité de :

- Réduire la complexité grâce aux abstractions de conteneurs : Les conteneurs ne nécessitent pas de dépendances sur l’infrastructure de l’application. Ainsi, vous n’avez pas besoin d’une interface native complexe pour gérer les services de la plateforme.

- Tirer profit de l’automatisation pour maximiser la portabilité : L’automatisation a remplacé le scriptage manuel. De nos jours, il est beaucoup plus difficile de garantir la portabilité lors de l’utilisation de l’automatisation.

- Fournir une meilleure sécurité et gouvernance, à l’extérieur des conteneurs : Les services de sécurité et de gouvernance sont propres à une plate-forme et non à une application spécifique. Le fait de placer des services de sécurité et de gouvernance en dehors du conteneur réduit considérablement la complexité.

- Fournir des capacités de calcul distribuées et améliorées : Cela est dû au fait qu’une application peut être divisée en plusieurs domaines, mais ils résident tous dans les conteneurs. L’aspect de portabilité des conteneurs signifie qu’ils peuvent s’exécuter sur un certain nombre de plates-formes cloud différentes. Cela permet aux ingénieurs de choisir les plateformes sur lesquelles ils s’exécutent, en fonction des coûts et des performances.

- Fournir des services d’automatisation qui tirent parti de l’optimisation basée sur les stratégies : Il doit y avoir une couche d’automatisation capable de localiser la meilleure plate-forme à exécuter et de migrer automatiquement vers cette plate-forme. En même temps, il doit gérer automatiquement les changements de configuration nécessaires.

Comment mettre à l’échelle les applications basées sur des conteneurs ?

La plupart de ceux qui cherchent à mettre à l’échelle les conteneurs adoptent l’une des deux approches fondamentales suivantes :

- La première approche consiste à créer un système personnalisé pour gérer les conteneurs. Cela signifie un système unique que vous construisez pour lancer automatiquement de nouvelles instances de conteneur si nécessaire pour gérer une charge de traitement croissante. Mais rappelez-vous que vous ne le possédez que si vous le construisez. Comme pour de nombreuses approches de bricolage, la maintenance deviendra coûteuse en main d’œuvre et en coûts.

- La deuxième approche consiste à tirer parti de l’une des technologies d’orchestration de conteneur, de planification et de mise en cluster qui fournira les mécanismes de base permettant l’évolutivité. C’est normalement le meilleur des deux options.

Il existe quelques choix pour la deuxième approche :

Tout d’abord, Google Kubernetes est un manager de cluster de conteneurs open-source, un peu comme Docker Swarm (voir ci-dessous). Kubernetes peut planifier n’importe quel nombre de réplicas de conteneur à travers un groupe d’instances de nœud. Cette astuce de réplication et de distribution de conteneur est généralement suffisante pour que la plupart des applications basées sur des conteneurs évoluent selon les besoins. C’est à peu près la même approche pour la mise à l’échelle des conteneurs que les autres outils utilisent.

Deuxièmement, Cloudify fournit un outil d’orchestration Docker qui chevauche Docker Compose et Docker Swarm. Ses concepts basés sur YAML permettent aux développeurs de décrire des topologies complexes, y compris l’infrastructure, le niveau middleware et les couches d’application. Il est davantage axé sur l’orchestration et doit donc être pris en compte lors de l’examen des outils d’orchestration et d’automatisation lorsque le clustering n’est pas nécessaire.

Enfin, l’outil le plus récent, Docker Swarm, offre des capacités de regroupement (clustering), de planification et d’intégration. Cet outil permet aux développeurs de créer et d’expédier des applications distribuées multi-conteneurs/multi-hôtes incluant la mise à l’échelle et la gestion nécessaires pour les systèmes basés sur des conteneurs. Évidemment, Swarm est conçu pour concurrencer Kubernetes qui a une plus grande part de marché. Considérez les deux outils lorsqu’il y a un besoin de mise à l’échelle massive des conteneurs.

Les meilleures pratiques continuent d’émerger autour de la mise à l’échelle des conteneurs, notamment :

- Consacrer du temps à l’architecture de vos applications basées sur des conteneurs. La plupart des problèmes de mise à l’échelle sont attribuables à des conceptions médiocres, et non à une technologie médiocre.

- Toujours faire une preuve de concept pour déterminer les capacités de mise à l’échelle réelle des solutions que vous envisagez. Utilisez des outils de test automatisés pour simuler les charges de travail et les quantités massives de données à tester.

- Considérez vos propres exigences. Ce qui fonctionne pour d’autres grandes entreprises peut ne pas convenir à vos applications basées sur des conteneurs.

- Ne pas oublier la sécurité et la gouvernance. Ils doivent aussi évoluer.

La mise à l’échelle des conteneurs sera un peu difficile jusqu’à ce qu’on comprenne mieux comment les conteneurs se comportent à l’échelle. Cependant, avec une bonne compréhension de la bonne utilisation des conteneurs et de la bonne technologie, vous serez évolutif dès le début.

Comprendre les étapes

Si vous utilisez déjà Linux, l’installation de Docker ne sera pas si complexe. Cependant, l’installation de Docker sur un Mac ou Windows nécessitera quelques étapes supplémentaires. Suivez simplement les instructions appropriées du système d’exploitation.

L’étape suivante consiste à tenter d’exécuter une application dockerisée. Docker a compilé un registre public des applications disponibles sous forme d’images Docker, et cette communauté fournit de nombreux points de départ pour la construction et l’exécution de vos propres applications basées sur des conteneurs.

Une fois que Docker est installé et en ligne, exécutez une image de l’application Docker en saisissant :

sudo docker run --rm -p 3000:3000 nom_image

Notez que la commande “docker run” ci-dessus exécute une image appelée image_name. S’il ne peut pas trouver l’image sur votre système local, il vérifiera le registre public et l’invoquera ici, s’il l’a trouvé.

Le conteneur Docker est simplement une instance d’une image Docker, tout comme les applications sont des instances d’exécutables qui existent en mémoire. Toutefois, vous pouvez lancer plusieurs instances isolées de l’application en tant que conteneurs sur un seul hôte. En ajoutant “-rm” à la commande, comme indiqué ci-dessus, Docker reçoit l’instruction de retirer le conteneur de la mémoire une fois sa tâche terminée. Cela a pour effet de supprimer toutes les modifications apportées à l’environnement local que l’application a pu effectuer mais conserve l’image mise en cache.

La construction d’une image Docker pour une application nécessite le démarrage du système d’exploitation principal avec une image de base qui s’exécute dans Docker. Ensuite, installez et configurez les outils nécessaires, puis utilisez la commande Docker “commit” pour enregistrer le conteneur en tant qu’image. Enfin, ajoutez-la dans le registre d’images Docker public ou gardez-la privé.

Une autre façon de créer une image est de noter les étapes nécessaires pour construire l’image dans un fichier Dockerfile bien formé. Cela automatise le processus d’installation et de configuration de l’application, créant ainsi un processus reproductible.

Comme pour tout processus de développement, vous devez comprendre plus de détails pour maîtriser la création et l’exécution d’images et de conteneurs Docker. À bien des égards, le succès des conteneurs et Docker s’est tourné autour de la facilité de développement. À mesure que la norme et le produit progresseront, les choses deviendront probablement encore plus faciles.

Un conteneur dans chaque magasin

On a souvent tendance à dire que les nouvelles façons de construire des systèmes seront la façon dont nous construirons des systèmes pour les années à venir. Bien que cela n’ait pas été le cas dans le passé, cela pourrait être le cas avec les conteneurs.

Les conteneurs fournissent une technologie d’activation standard et utile, et également un parcours vers l’architecture de l’application qui offre à la fois une distribution gérée et une orientation de service. Nous essayons d’atteindre cet état depuis des années mais nous n’avons pas encore réussi.

Ce qui est peut-être le plus convaincant, c’est l’avantage de la portabilité des conteneurs, et cela reste le cri de guerre des fournisseurs de technologie de conteneurs de nos jours. Cependant, il faudra des années avant que nous comprenions vraiment la véritable valeur des conteneurs, car nous déplaçons des applications conteneurisées du cloud au cloud.

Supposons que cette dynamique se poursuive ainsi, les conteneurs feront partie de la plupart des magasins informatiques dans le futur, qu’ils se déplacent vers le cloud ou non. La viabilité et la polyvalence de cette technologie seront des choses que nous continuerons d’explorer et d’exploiter au cours des prochaines années. Compter sur le fait que quelques erreurs seront commises, l’impact global des conteneurs est cependant une fatalité.