Voici les utilisations les plus courantes du cloud et les composants Amazon Web Services (AWS) dont vous avez besoin pour ce faire.

Les services Cloud passent de l’état initial « nous le faisons parce que tout le monde le fait » à une migration plus prudente et planifiée, où les départements informatiques ont évalué avec soin leurs besoins et déterminé ce qu’il faut transférer vers le cloud et ce qui va rester sur le site.

Le transfert de données nécessite la compréhension de quelques leçons difficiles. Une étude menée par IDG Research a révélé que jusqu’à 40% des charges de travail quittaient le cloud pour revenir à un environnement local. C’est parce que les entreprises avaient la notion erronée qu’elles pourraient se déplacer vers le cloud et continuer à fonctionner comme elles le pouvaient dans leur environnement local, et pourtant ce n’est pas le cas.

Un élément qu’on peut déterminer le cloud est son élasticité. Sa valeur est dans la capacité de transmission, donnant aux clients une augmentation rapide de la puissance de calcul ou de l’accès aux services dans le plus bref délai, puis la possibilité de l’éteindre et de ne plus payer lorsque ceci est terminé. Mais, quels services cloud peuvent offrir un tel avantage ?

Pour faciliter ce processus, voici une liste des utilisations les plus courantes du cloud et des composants Amazon Web Services que vous avez besoin pour cela. AWS est bien sûr la plate-forme cloud la plus populaire aujourd’hui.

Par défaut, tous ces services supposent que vous utiliserez EC2, S3 et Amazon Data Transfer. Ils forment le noyau de base que tout le monde utilise pour construire leurs produits.

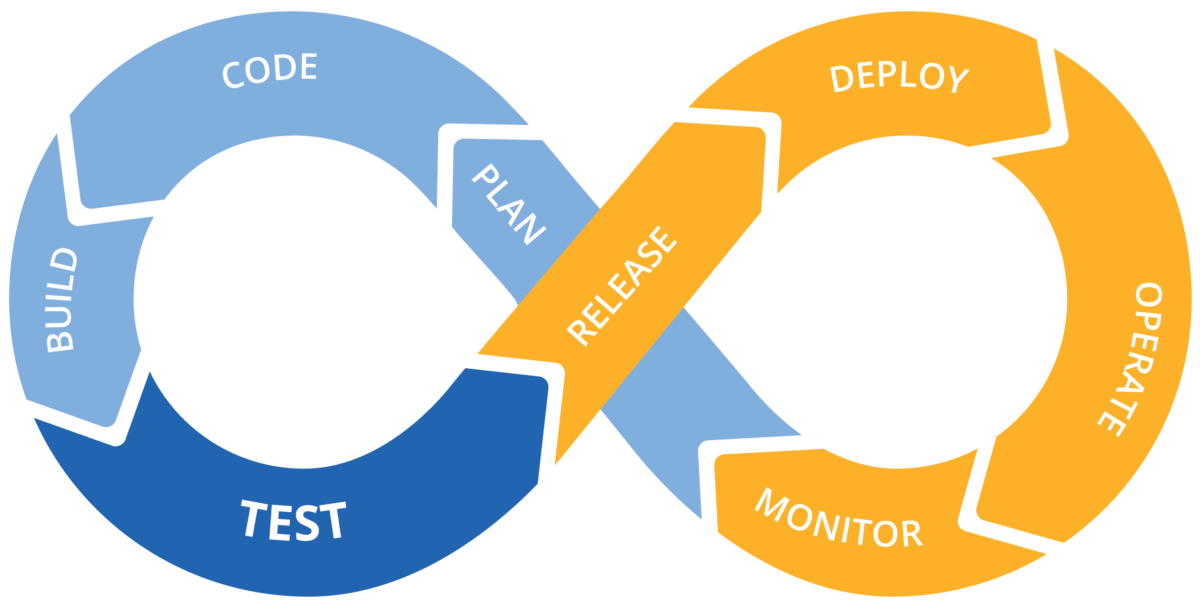

Services AWS pour devops, développement de logiciels et tests

Les développeurs trouvent qu’il est facile de créer une instance ; développer, compiler et tester en ligne ; puis éteindre le VM une fois terminé. Le but est de garder les données en utilisation et de les éteindre lorsqu’elles ne sont pas utilisées.

Vous commencez avec les bases : AWS Developer Tools. Cet ensemble de quatre services vous permet de construire et de diffuser régulièrement des mises à jour d’applications. Les quatre services sont :

- AWS CodeCommit, pour stocker du code dans un référentiel Git privé

- AWS CodePipeline, pour une intégration et une livraison continues

- AWS CodeBuild, pour générer et tester le code

- AWS CodeDeploy, pour automatiser les déploiements de code

Les applications créées avec Developer Tools peuvent s’exécuter sur AWS ou sur le site.

Pour les cas spécialisés, il existe plusieurs autres services liés au code :

- Amazon Elastic Container Service (ECS) est un service de gestion de conteneur hautement évolutif et de haute performance qui prend en charge les conteneurs Docker à exécuter dans une instance.

- Si vous expérimentez avec l’informatique sans serveur, AWS Lambda vous permet d’exécuter du code sans avoir à provisionner ou gérer des serveurs. Il prend en charge virtuellement tout type d’application ou de service backend sans administration.

- Deux services prennent en charge le provisionnement d’infrastructure-comme-code (IAC). IAC est un processus dans lequel des systèmes tels que des machines virtuelles sont automatiquement créés, gérés et provisionnés via le code, plutôt que par le biais de scripts moins souples ou d’un processus manuel. C’est pourquoi l’infrastructure en tant que code est parfois appelée infrastructure programmable.

Ensuite vient la gestion :

- AWS CloudFormation fournit aux développeurs et aux administrateurs système des modèles pour créer et gérer une collection de ressources AWS connexes, les provisionner et les mettre à jour selon les besoins.

- AWS OpsWorks est un service de gestion de configuration qui utilise Chef, une plate-forme d’automatisation qui traite les configurations de serveur comme du code. Les applications sont déployées sur une instance EC2 ou votre environnement local.

Tout cela peut être construit sur les services réseau AWS pour répliquer votre propre infrastructure. Amazon Virtual Private Cloud (VPC) vous permet de lancer AWS dans un réseau virtuel que vous avez défini. Par conséquent, si vous créez des applications sur le site, cela peut ressembler à votre propre infrastructure.

Enfin, pour éviter une facturation très élevée, AWS CloudWatch propose des mesures sur le transfert de données, l’utilisation du disque et l’utilisation du processeur. Vous pouvez configurer des alertes lorsque certains seuils sont dépassés pour maîtriser la facture mensuelle.

Services AWS pour l’archivage à long terme et la reprise après sinistre

La plupart des entreprises font leurs sauvegardes et leurs archives à long terme sur le site, mais que se passe-t-il s’il y a un incendie dans le centre de données, où conservez-vous vos sauvegardes ? La sauvegarde hors site est la mesure la plus sûre, et vous pouvez certainement utiliser AWS pour la sauvegarde à long terme et la reprise après sinistre.

Le principal service de sauvegarde pour AWS est Glacier, pour lequel Amazon promet une durée de vie de 99,999999999% ainsi qu’une conformité réglementaire totale. Vous pouvez également exécuter des analyses sur les données. Vous pouvez stocker des données à un tarif intéressant allant jusqu’à 0,004 $ par gigaoctet par mois.

Cependant, Glacier a ses inconvénients, puisqu’un consommateur a découvert qu’il n’est pas la bonne solution à adopter : Glacier est censé contenir des données mais pas beaucoup. Comme ce client l’a appris, vous ne pouvez récupérer que 5% de votre espace de stockage total gratuitement. Au-delà de ce volume, la récupération sera payante, et ce coût peut s’additionner rapidement. Donc, si vous prévoyez de récupérer des données régulièrement ou même semi-mensuellement, un service de sauvegarde comme BackBlaze, Dropbox ou OneDrive pourrait être une meilleure résolution.

Aussi, tout comme les glaciers se déplacent à un rythme ridiculement lent, ne vous attendez pas à obtenir vos données immédiatement. Une demande peut prendre jusqu’à un jour pour se terminer. En 2016, Amazon a ajouté de nouvelles options pour accélérer la récupération. Pour les utilisateurs ayant 100 To ou plus de données stockées, vous pouvez accélérer la récupération pour 0,03 $ par gigaoctet et 0,01 $ par demande, ce qui est une prime par rapport au coût standard de 0,01 $ par gigaoctet et de 0,050 $ par 1 000 demandes.

Pour la reprise après sinistre, vous utilisez diverses parties d’AWS.

D’abord, vous devez choisir la région du centre de données où vos données seront stockées pour de nombreuses raisons, telles que la conformité aux exigences de stockage, et pour gérer la latence.

À partir de là, vous utilisez Amazon Simple Storage Service (S3), Glacier, AWS Elastic Block Storage pour créer des instantanés de volumes de données, AWS Import/Export (Snowball) et AWS Storage Gateway pour connecter votre appliance logicielle locale au stockage basé sur le cloud. Ce sont tous des services, mais Snowball est une solution décidément hors ligne.

Transférer de nombreux téraoctets de données vers le centre de données d’Amazon peut devenir prohibitif, aussi Amazon envoie une appliance Snowball résistante au choc à votre installation afin que vous puissiez connecter à votre réseau et transfériez d’énormes quantités de données. Vous la renvoyez à Amazon et elle est ajoutée à votre compte de stockage. Et si vous avez beaucoup de données, il y a le Snowmobile, un véhicule à 18 roues avec un conteneur de 45 pieds pouvant transporter jusqu’à 100 pétaoctets de données.

Services AWS pour l’analyse

AWS est une excellente ressource pour un type d’analyse particulier. Si vous cherchez à recueillir des informations à partir des ressources cloud, c’est-à-dire des données collectées à partir du cloud et d’Internet en général, cela fonctionne bien. Mais, si vous souhaitez envoyer le contenu de votre entrepôt de données au cloud pour le traitement et renvoyer les résultats, AWS n’est pas recommandé car les coûts vont augmenter considérablement. Cependant, Amazon prendra en charge un tel traitement si vous voulez obtenir ces fonctionnalités.

Amazon a un ensemble d’outils d’analyse complet, en commençant par Athena pour l’analyse des données stockées dans les instances S3, EMR pour Hadoop, QuickSight pour l’analyse commerciale, Redshift pour un entrepôt de données pétaoctet, Glue pour effectuer des tâches ETL sur les magasins de données et Data Pipeline pour déplacer des données en toute sécurité. Plus récemment, il a ajouté AWS IoT Analytics au menu pour, quoi d’autre, l’analyse des capteurs IoT et d’autres données recueillies par les appareils IoT.

Athena est le principal service d’analyse fonctionnant sur les données qui résident dans S3. Il prend en charge une variété de formats de données, y compris ORC, JSON, CSV et Parquet. Les données peuvent et doivent être converties en formats colonnaires à l’aide d’Apache Parquet. Athena utilise Presto, un moteur de recherche open source, comme moteur de recherche SQL.

Pour l’intelligence professionnelle, AWS met l’accent sur Redshift. C’est une base de données massivement parallèle, orientée colonne, déployée en tant que cluster pour un traitement parallèle massif. (Vous ne pouvez même pas déployer un seul nœud de Redshift.) Elle est conçue pour les charges de travail de type OLAP telles que les entrepôts de données, les analyses et ETL.

Redshift est destiné aux utilisateurs d’entrepôts de données plus avancés. Pour la visualisation des données clients, il y a QuickSight, un service BI. Il utilise des données stockées dans n’importe quel référentiel Hadoop, un entrepôt de données Amazon Redshift ou des sources tierces telles que Salesforce.com et Oracle.

Services AWS pour les applications et les sites Web “pop-up”

Un programme de marketing à court terme pour quelque chose qui ressemble à un premier film ou un lancement de produit signifie un site dédié qui aura beaucoup d’activités pendant une courte période et ensuite mourir. Au lieu de passer par le processus de création de votre propre site pour des besoins aussi éphémères, ou d’utiliser un service comme GoDaddy ou 1and1, AWS offre une variété de services d’hébergement Web à l’échelle.

Le service Simple Website Hosting est un serveur Web unique avec un système de gestion de contenu (CMS) tel que WordPress, une application e-commerce telle que Magento, ou une pile de développement comme LAMP. Il est parfait pour les sites à trafic faible ou moyen avec des changements de contenu fréquents, car il ne peut pas dépasser plus de cinq serveurs.

Ensuite, il y a Lightsail, qui est conçu pour les sites qui ne nécessitent pas des langages de scripts côté serveur comme PHP ou ASP.Net, mais qui ont besoin d’être mis à l’échelle lors de l’augmentation occasionnelle du trafic. Il offre un stockage et une gestion des données avec un enregistrement IP et un DNS statique.

Enfin, il y a Enterprise Web Hosting, qui fournit plusieurs serveurs à travers au moins deux centres de données, pour vous offrir une grande capacité avec l’équilibrage de charge, l’utilisation élevée du processeur et beaucoup d’applications. Vous utiliserez une variété de services, notamment CloudFront, un réseau de diffusion de contenu, ainsi que des applications e-commerce AWS pour gérer les ventes en ligne.

Services AWS pour la migration des applications

C’est l’un des principaux arguments de vente d’AWS. Au lieu d’exécuter des applications sur vos systèmes locaux, vous pouvez les migrer vers AWS et les exécuter dans le cloud, supprimant ainsi le besoin de gérer un centre de données volumineux.

Mais, ce ne sont pas toutes les applications qui sont prêtes à être migrées vers le cloud :

- Les applications qui doivent fonctionner 24 heures sur 24 et 7 jours sur 7, par exemple, ne sont pas adaptées au cloud, où tout est mesuré et vous payez pour chaque cycle d’horloge du processeur.

- Les applications où de nombreuses données doivent circuler entre le cloud et votre réseau ne sont pas compatibles avec le cloud, car l’utilisation de la bande passante est également mesurée.

- Il peut y avoir des problèmes de conformité. Bien qu’Amazon et ses concurrents aient fait de grands pas vers la conformité HIPAA pour les enregistrements médicaux, par exemple, certaines choses doivent rester dans les limites du centre de données d’une entreprise.

Tout à fait logique, la migration vers le cloud nécessite une planification et une évaluation très minutieuses des applications qui peuvent et doivent être déplacées vers son stockage. Une fois que vous avez éclairci cet obstacle de taille, vous utilisez un service AWS récemment ajouté appelé Server Migration Service pour vous aider à effectuer la migration. Il est livré avec un connecteur pour analyser votre environnement de serveur virtualisé et collecter des informations sur les instances que vous utilisez.

À partir de là, la machine virtuelle est reproduite en tant qu’image AMI (Amazon Machine Image) stockée dans le service AWS Elastic Block Store (EBS). L’AMI peut ensuite être déplacée et exécutée sur une instance EC2. À ce stade, vous disposez d’une réplique de votre instance virtuelle locale sur AWS.

Vous pouvez également migrer de MySQL vers Amazon RDS, tout comme vous le feriez pour une autre base de données sur votre réseau. Pour les charges de travail plus analytiques, telles qu’OLAP, les outils de leurs fournisseurs vous aideront à migrer depuis le site vers une AMI de base de données EC2, tout comme ils aideraient lors de la migration de données d’une machine à une autre.